File robots.txt là gì?

Robots.txt là một tập tin văn bản chứa các chỉ dẫn cho BOT công cụ tìm kiếm, cho biết những trang nào nên hoặc không nên thu thập thông tin. Các chỉ dẫn này được xác định bằng cách “cho phép” hoặc “không cho phép” hành vi của một số (hoặc tất cả) bot.

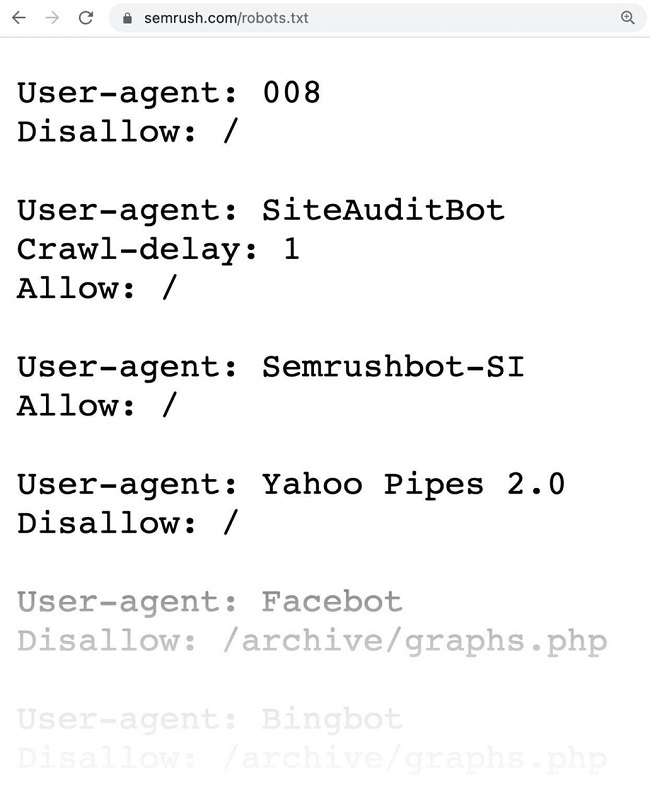

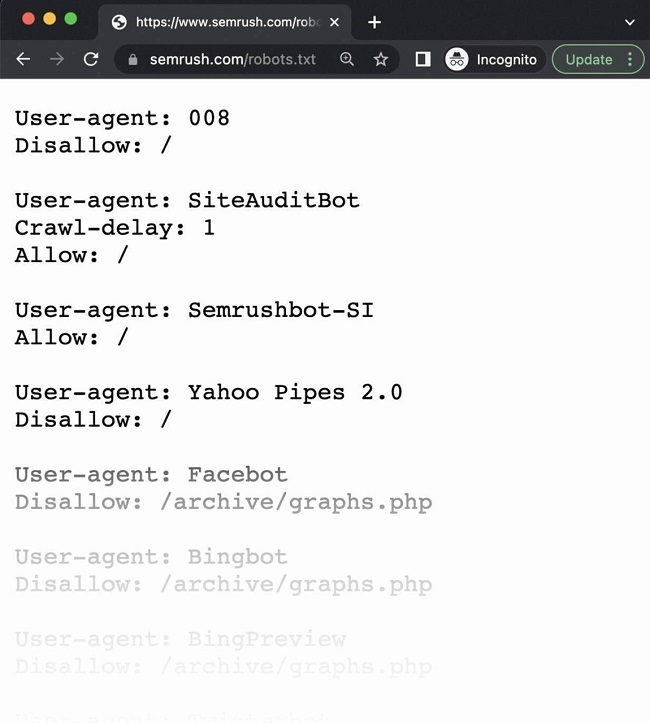

Một tệp robots.txt có dạng như sau:

Tầm quan trọng của file robots.txt

Tệp robots.txt là một tệp quan trọng trong việc quản lý hoạt động của các trình thu thập thông tin trên web, giúp ngăn chặn chúng quá tải trang web của bạn và ngăn chặn việc lập chỉ mục các trang không dành cho người dùng thông thường. Điều này giúp bảo vệ thông tin không cần thiết trên trang web, tránh khỏi việc những trang này xuất hiện trên kết quả tìm kiếm của công cụ tìm kiếm.

Ngoài ra, tệp robots.txt còn giúp tối ưu hóa quá trình thu thập thông tin bằng cách cho phép các trình thu thập thông tin tập trung vào các trang quan trọng hơn.

File robots.txt hoạt động như thế nào?

Tệp Robots.txt cho phép bot của công cụ tìm kiếm biết được những URL nào có thể cào/phân tích và những URL nào nên bị bỏ qua. Công cụ tìm kiếm phục vụ hai mục đích chính:

- Cào/phân tích web để khám phá nội dung.

- Lập chỉ mục và cung cấp nội dung cho người tìm kiếm thông tin.

Khi các bot cào/phân tích nội dung các trang web, chúng sẽ khám phá và theo dõi các liên kết. Quá trình này dẫn chúng từ trang A đến trang B và C trên hàng triệu liên kết, các trang. Tuy nhiên, nếu bot tìm thấy tệp robots.txt, nó sẽ đọc nó trước khi làm bất cứ điều gì khác.

Cú pháp của tệp này rất đơn giản.

- Gán các quy tắc bằng cách xác định user-agent (bot của công cụ tìm kiếm), tiếp theo là các cú pháp (quy tắc).

- Bạn cũng có thể sử dụng ký tự đại diện (*) để gán các cú pháp cho mọi user-agent, áp dụng quy tắc cho tất cả bot.

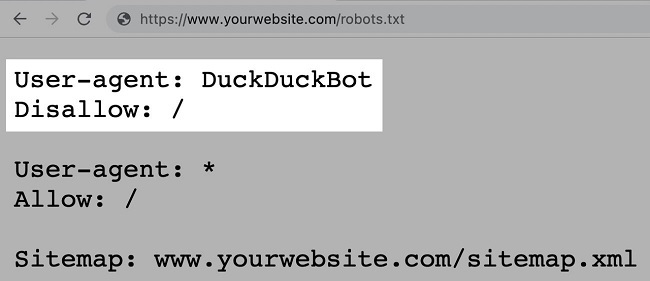

Ví dụ: cú pháp dưới đây cho phép tất cả các bot trừ DuckDuckGo đọc trang web của bạn:

Cách tìm file robots.txt

Tệp robots.txt được lưu trữ trên máy chủ, giống như bất kỳ tệp nào khác trên website của bạn.

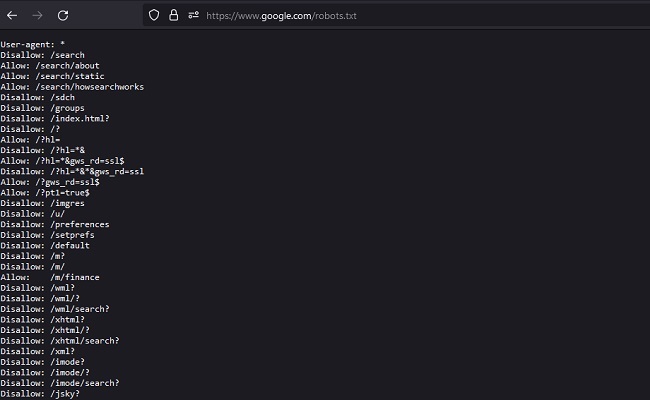

Bạn có thể xem tệp robots.txt của bất kỳ trang web nào bằng cách gõ đầy đủ URL của trang chủ và thêm “/robots.txt” vào cuối. Ví dụ: https://www.google.com/robots.txt.

File robots.txt phải nằm trong thư mục gốc của trang web của bạn và có đường dẫn là /robots.txt.

Ví dụ, đối với trang web www.example.com, tệp robots.txt sẽ được đặt tại đường dẫn www.example.com/robots.txt. Việc đặt tệp này ở một vị trí khác sẽ khiến cho các công cụ tìm kiếm không thể tìm thấy và đọc nó. Do đó, không thể chấp nhận các cú pháp và quy tắc được định nghĩa trong tệp robots.txt của bạn.

Cú pháp robots.txt

File robots.txt được tạo thành bởi:

- Một hoặc nhiều khối “directives” (quy tắc)

- Mỗi khối có một “user-agent” cụ thể (bot của công cụ tìm kiếm)

- Và một cú pháp “allow” hoặc “disallow”

Một khối đơn giản có thể có dạng như sau:

User-agent: Googlebot

Disallow: /not-for-google

User-agent: DuckDuckBot

Disallow: /not-for-duckduckgo

Sitemap: https://www.yourwebsite.com/sitemap.xmlTrong đó:

- Khối quy tắc đầu tiên áp dụng cho bot của Google, được chỉ định bằng user-agent: Googlebot. Quy tắc này chỉ ra rằng Googlebot không được phép truy cập vào bất kỳ trang nào có đường dẫn bắt đầu bằng /not-for-google. Điều này có nghĩa là các trang web được liệt kê trong thư mục /not-for-google sẽ không được hiển thị trong kết quả tìm kiếm của Google.

- Khối quy tắc thứ hai áp dụng cho bot của DuckDuckGo, được chỉ định bằng user-agent: DuckDuckBot. Quy tắc này chỉ ra rằng DuckDuckBot không được phép truy cập vào bất kỳ trang nào có đường dẫn bắt đầu bằng /not-for-duckduckgo. Điều này có nghĩa là các trang web được liệt kê trong thư mục /not-for-duckduckgo sẽ không được hiển thị trong kết quả tìm kiếm của DuckDuckGo.

- Tệp robots.txt này cũng chứa một cú pháp Sitemap: để chỉ định cho các công cụ tìm kiếm biết vị trí của tệp sitemap.xml của trang web. Điều này giúp cho các công cụ tìm kiếm có thể hiểu được cấu trúc của trang web và tìm kiếm các trang web mới được thêm vào trang web nhanh chóng hơn.

Cú pháp User-Agent

Dòng đầu tiên của mỗi khối cú pháp là user-agent, xác định trình thu thập dữ liệu.

Ví dụ, nếu bạn muốn cho Googlebot biết không nên thu thập trang quản trị WordPress của bạn, thì cú pháp của bạn sẽ bắt đầu bằng:

User-agent: Googlebot

Disallow: /wp-admin/Lưu ý: Hầu hết các công cụ tìm kiếm có nhiều trình thu thập dữ liệu. Chúng sử dụng các trình thu thập dữ liệu khác nhau cho việc lập chỉ mục tiêu chuẩn, hình ảnh, video, v.v. Khi nhiều cú pháp có sẵn, trình thu thập dữ liệu có thể chọn khối cú pháp cụ thể nhất.

Cú pháp Disallow trong Robots.txt

Dòng thứ hai trong một cú pháp Robots.txt là dòng “Disallow“. Bạn có thể có nhiều cú pháp Disallow để chỉ ra phần nào của trang web mà trình thu thập dữ liệu không thể truy cập.

Một dòng “Disallow” trống có nghĩa là bạn không cấm bất cứ điều gì – một trình thu thập dữ liệu có thể truy cập tất cả các phần của trang web của bạn.

Ví dụ, nếu muốn cho phép tất cả các công cụ tìm kiếm thu thập dữ liệu trên toàn bộ trang web , bạn có thể sử dụng các khối quy tắc như sau:

User-agent: *

Allow: /Nếu bạn muốn chặn tất cả các công cụ tìm kiếm khác không được truy cập trang web của bạn, quy tắc sẽ trông như thế này:

User-agent: *

Disallow: /Lưu ý: Các cú pháp như “Allow” và “Disallow” không phân biệt chữ hoa chữ thường. Tuy nhiên, các giá trị trong mỗi cú pháp lại là phân biệt chữ hoa chữ thường.

Ví dụ, /photo/ sẽ khác với /Photo/. Tuy nhiên, thông thường các cú pháp “Allow” và “Disallow” được viết hoa để giúp cho tệp trở nên dễ đọc hơn.

Cú pháp Allow

Cú pháp “Allow” cho phép các công cụ tìm kiếm thu thập dữ liệu trên một thư mục con hoặc trang cụ thể, ngay cả khi thư mục chính đã bị cấm truy cập.

Ví dụ, nếu bạn muốn ngăn Googlebot truy cập vào mọi bài đăng trên blog của bạn, trừ một bài đăng cụ thể, cú pháp của bạn có thể như sau:

User-agent: Googlebot

Disallow: /blog

Allow: /blog/vi-du-bai-dangLưu ý: Không phải tất cả các công cụ tìm kiếm đều có thể nhận ra lệnh này. Tuy nhiên, Google và Bing đều hỗ trợ cú pháp này.

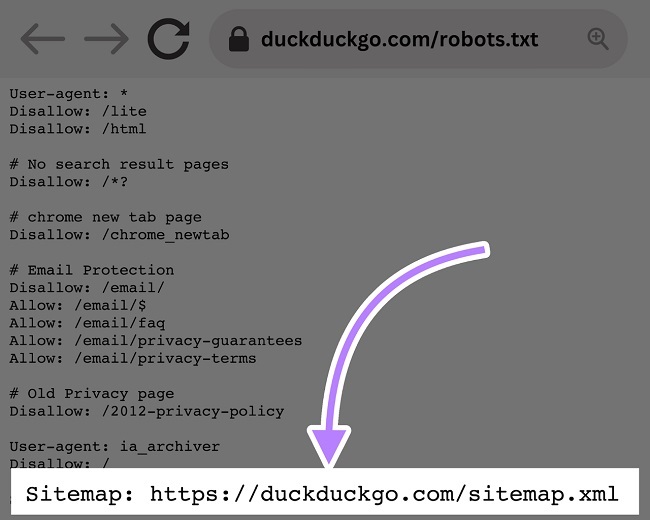

Cú pháp Sitemap

Cú pháp Sitemap cho biết cho các công cụ tìm kiếm như Bing, Yandex và Google tìm thấy sơ đồ trang web XML của bạn. Sơ đồ trang web thông thường bao gồm các trang mà bạn muốn các công cụ tìm kiếm thu thập dữ liệu và lập chỉ mục. Cú pháp này được đặt ở đầu hoặc cuối tệp robots.txt và có dạng như sau:

Thêm cú pháp Sitemap vào tệp robots.txt là một phương án nhanh chóng. Tuy nhiên, bạn cũng có thể gửi sơ đồ trang web XML cho công cụ tìm kiếm bằng cách sử dụng các công cụ quản trị web. Các công cụ tìm kiếm sẽ thu thập dữ liệu trang web của bạn cuối cùng, nhưng việc gửi sơ đồ trang web sẽ giúp tăng tốc quá trình thu thập dữ liệu website.

Cú pháp Crawl-Delay

Cú pháp crawl-delay hướng dẫn trình thu thập dữ liệu trì hoãn tốc độ thu thập dữ liệu. Điều này giúp tránh quá tải máy chủ. Google hiện không còn hỗ trợ cú pháp crawl-delay. Nếu bạn muốn đặt tốc độ thu thập dữ liệu cho Googlebot, bạn sẽ phải làm điều đó trong Google Search Console.

Tuy nhiên, Bing và Yandex vẫn hỗ trợ cú pháp crawl-delay. Dưới đây là cách sử dụng nó.

Giả sử bạn muốn trình thu thập dữ liệu đợi 10 giây sau mỗi hành động thu thập dữ liệu. Đặt độ trễ là 10 như sau:

User-agent: *

Crawl-delay: 10Cú pháp Noindex

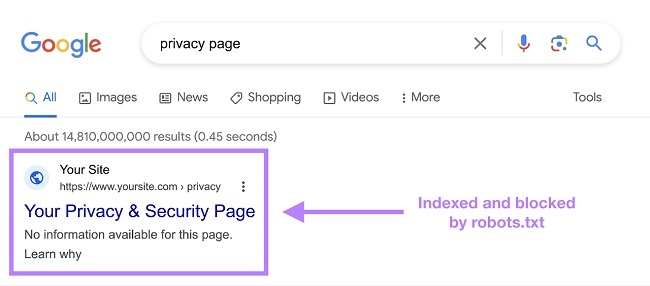

Tệp robots.txt chỉ cho bot biết nó có thể hoặc không thể thu thập dữ liệu, nhưng nó không thể cho bot tìm kiếm biết các URL nào không được lập chỉ mục và hiển thị trong kết quả tìm kiếm

Trang vẫn sẽ xuất hiện trong kết quả tìm kiếm, nhưng con bot sẽ không biết nó chứa những gì, do đó trang của bạn sẽ xuất hiện như sau:

Ví dụ trang được lập chỉ mục và bị chặn bởi robots.txt trong kết quả tìm kiếm

Xem thêm: File .htaccess WordPress là gì? Cách Chỉnh Sửa file .htaccess Đơn Giản Nhất

4 Bước tạo file robots.txt đơn giản Nhanh chóng

Sau đây là hướng dẫn tạo file robots.txt với 4 bước đơn giản

Bước 1: Tạo một tệp Robots.txt

Bắt đầu bằng cách tạo một tài liệu .txt trong một trình soạn thảo văn bản hoặc trình duyệt web.

Lưu ý: Không sử dụng trình xử lý văn bản, vì chúng thường lưu tệp trong định dạng độc quyền có thể thêm ký tự ngẫu nhiên.

Đặt tên tài liệu là robots.txt.

Bây giờ bạn đã sẵn sàng bắt đầu nhập các cú pháp.

Bước 2: Thêm các cú pháp vào tệp Robots.txt

Tệp robots.txt bao gồm một hoặc nhiều nhóm cú pháp, và mỗi nhóm bao gồm nhiều dòng lệnh.

Mỗi nhóm bắt đầu với một “user-agent” và có thông tin sau đây:

- Nhóm này áp dụng cho ai (user-agent)

- Thư mục (trang) hoặc tệp mà agent có thể truy cập

- Thư mục (trang) hoặc tệp mà agent không thể truy cập

- Một sơ đồ trang web để cho biết các trang và tệp mà bạn coi là quan trọng và cần được các công cụ tìm kiếm chú ý.

Các crawler sẽ bỏ qua các dòng không phù hợp với các cú pháp này.

Ví dụ, giả sử bạn không muốn Google lục tìm thư mục /clients/ của bạn vì nó chỉ dành cho sử dụng nội bộ.

Nhóm đầu tiên sẽ trông giống như sau:

User-agent: Googlebot

Disallow: /clients/Các cú pháp bổ sung có thể được thêm vào một dòng riêng biệt bên dưới, như sau:

User-agent: Googlebot

Disallow: /clients/

Disallow: /not-for-googleKhi bạn hoàn thành các cú pháp cụ thể của Google, hãy nhấn enter hai lần để tạo một nhóm cú pháp mới.

Hãy tạo một nhóm cú pháp này cho tất cả các công cụ tìm kiếm và ngăn chúng lục tìm các thư mục /archive/ và /support/ của bạn vì chúng chỉ dành cho sử dụng nội bộ. Nó sẽ trông như thế này:

User-agent: Googlebot

Disallow: /clients/

Disallow: /not-for-google

User-agent: *

Disallow: /archive/

Disallow: /support/Khi bạn hoàn thành, hãy thêm sơ đồ trang web của bạn. Tệp robots.txt của bạn sẽ trông như sau:

User-agent: Googlebot

Disallow: /clients/

Disallow: /not-for-google

User-agent: *

Disallow: /archive/

Disallow: /support/

Sitemap: https://www.yourwebsite.com/sitemap.xmlLưu tệp robots.txt của bạn. Hãy nhớ, nó phải có tên là robots.txt.

Lưu ý: Các crawler đọc từ trên xuống dưới và phù hợp với nhóm quy tắc cụ thể nhất đầu tiên. Vì vậy, hãy bắt đầu tệp robots.txt của bạn với các user agent cụ thể trước, sau đó chuyển sang ký tự đại diện tổng quát hơn (*) để phù hợp với tất cả các crawler.

Bước 3: Tải tệp Robots.txt lên

Sau khi bạn đã lưu tệp robots.txt vào máy tính của mình, hãy tải lên trang web của bạn và cho phép các công cụ tìm kiếm cào/phân tích nó.

Việc tải lên tệp robots.txt phụ thuộc vào cấu trúc tệp của trang web và dịch vụ lưu trữ web của bạn. Hãy tìm kiếm trực tuyến hoặc liên hệ với nhà cung cấp dịch vụ lưu trữ web của bạn để được hỗ trợ tải lên tệp robots.txt.

Ví dụ, bạn có thể tìm kiếm “tải lên tệp robots.txt cho WordPress”.

Dưới đây là một số bài viết giải thích cách tải lên tệp robots.txt của bạn trên các nền tảng phổ biến nhất:

- Tạo robots.txt cho WordPress

- Robots.txt file trên Wix

- Robots.txt file trên Joomla

- Robots.txt file trên Shopify

- Robots.txt file trên BigCommerce

Sau khi tải lên, hãy kiểm tra xem ai có thể xem nó và Google có thể đọc được nó hay không.

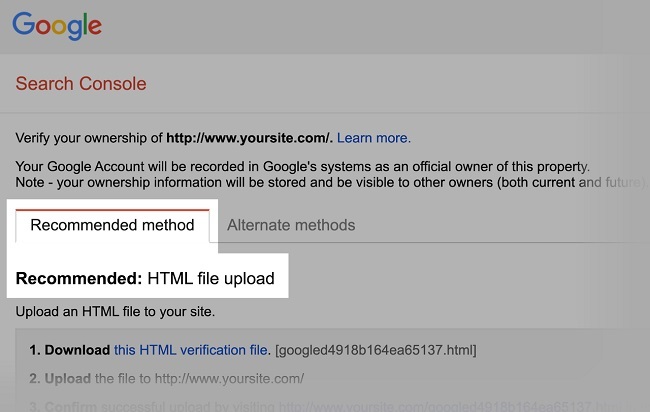

Bước 4: Kiểm tra tệp Robots.txt của bạn

Đầu tiên, hãy kiểm tra xem tệp robots.txt của bạn có thể truy cập công khai không (tức là nó đã được tải lên đúng cách hay chưa).

Mở một trình duyệt riêng tư và tìm kiếm tệp robots.txt của bạn.

Ví dụ: https://www.lanit.com.vn/robots.txt

Khi tệp robots.txt hiển thị nội dung mà bạn đã thêm, điều đó có nghĩa là tệp của bạn đã được tải lên thành công và các công cụ tìm kiếm sẽ đọc nó để biết các cú pháp về việc lập chỉ mục trang web của bạn.

Sau khi tệp robots.txt của bạn đã được xác nhận là hoạt động, bạn có thể tiếp tục kiểm tra các mã đánh dấu (HTML) khác để đảm bảo trang web của bạn được tối ưu hóa tốt nhất cho các công cụ tìm kiếm và người dùng.

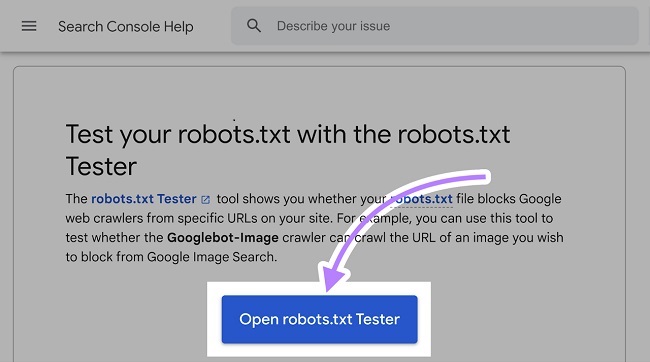

Google có hai tùy chọn cho việc kiểm tra mã đánh dấu robots.txt:

- Trình kiểm tra robots.txt trong Search Console

- Thư viện mã nguồn mở của Google về robots.txt (dành cho nhà phát triển nâng cao)

Vì tùy chọn thứ hai được thiết kế cho nhà phát triển nâng cao, vì vậy chúng ta sẽ tập trung vào việc kiểm tra tệp robots.txt trong Search Console.

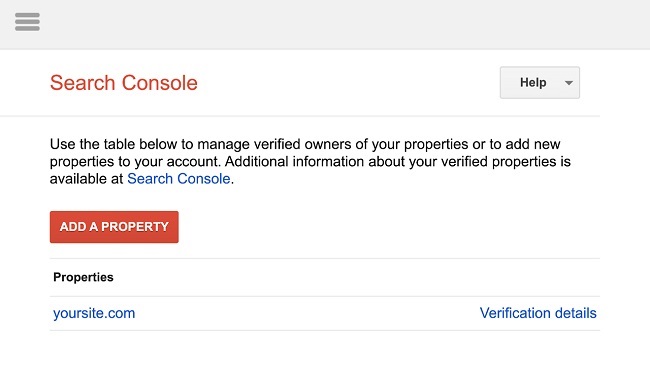

Lưu ý: bạn phải có một tài khoản Search Console đã được thiết lập để kiểm tra tệp robots.txt của mình.

Để kiểm tra tệp robots.txt, hãy truy cập Trình kiểm tra robots.txt trong Search Console và nhấp vào nút “Mở trình kiểm tra robots.txt”.

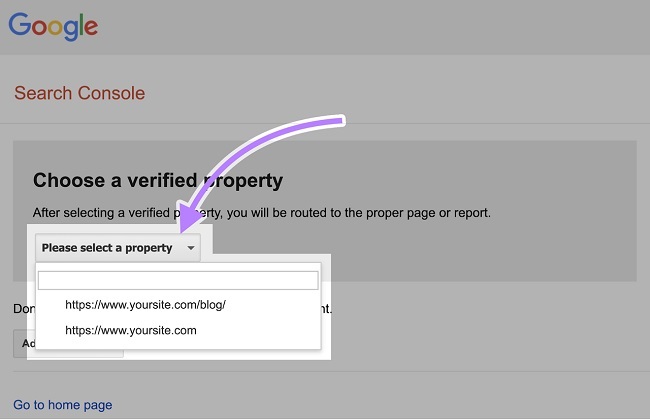

Bạn cần thêm thuộc tính trước tiên, nếu tài khoản Google của bạn chưa liên kết với Search Console.

Sau đó, xác minh bạn là chủ sở hữu thực sự của trang web.

Nếu bạn hiện có các thuộc tính đã được xác minh, hãy chọn một trong số chúng từ danh sách thả xuống trên trang chủ của Trình kiểm tra robots.txt.

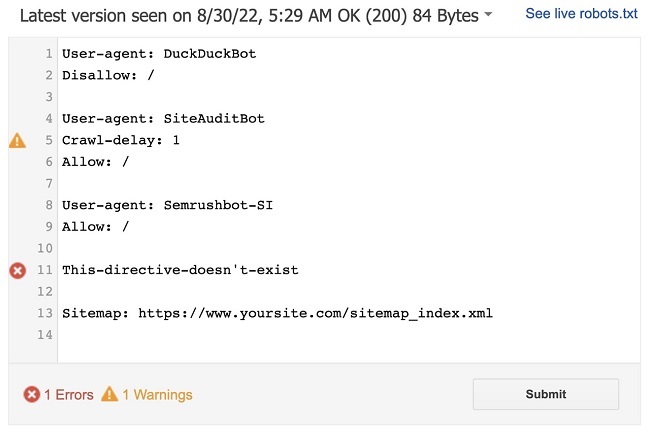

Trình kiểm tra sẽ xác định các cảnh báo cú pháp hoặc lỗi logic trong tệp robots.txt của bạn.

Nó sẽ hiển thị tổng số cảnh báo và lỗi bên dưới trình soạn thảo.

Bạn có thể chỉnh sửa các lỗi hoặc cảnh báo trực tiếp trên trang và kiểm tra lại theo dõi.

Bất kỳ thay đổi nào được thực hiện trên trang đều không được lưu vào trang web của bạn. Công cụ không thay đổi tệp thực tế trên trang web của bạn. Nó chỉ kiểm tra so với bản sao được lưu trữ trong công cụ.

Để thực hiện bất kỳ thay đổi nào, bạn chỉ cần sao chép và dán bản sao được chỉnh sửa vào tệp robots.txt trên trang web của bạn.

Lưu ý khi sử dụng file robots.txt

Sử dụng dòng mới cho mỗi cú pháp

Mỗi cú pháp nên đặt trên một dòng mới. Nếu không, các công cụ tìm kiếm sẽ không thể đọc và các cú pháp sẽ bị bỏ qua.

Sai:

User-agent: * Disallow: /admin/

Disallow: /directory/Đúng:

User-agent: *

Disallow: /admin/

Disallow: /directory/Mỗi lần sử dụng một User-Agent

Nhập nhiều user-agent cùng một lúc sẽ không ảnh hưởng đến các bot. Nhưng việc tham chiếu nó chỉ một lần giữ cho mọi thứ gọn gàng và giảm thiểu sai sót khi thực hiện.

Không nên:

User-agent: Googlebot

Disallow: /example-page

User-agent: Googlebot

Disallow: /example-page-2Nên:

User-agent: Googlebot

Disallow: /example-page

Disallow: /example-page-2Sử dụng ký tự để làm rõ cú pháp

Bạn có thể sử dụng ký tự (*) để áp dụng một cú pháp cho tất cả các user-agent và khớp với các mẫu URL.

Ví dụ, để ngăn các công cụ tìm kiếm truy cập vào các URL với các tham số, bạn có thể liệt kê chúng một cách cụ thể.

Tuy nhiên điều đó là không hiệu quả. Bạn có thể đơn giản hóa cú pháp của mình với một ký tự.

Không nên:

User-agent: *

Disallow: /color/red?

Disallow: /shoes/blue?

Disallow: /shoes/green?Nên:

User-agent: *

Disallow: /color/*?Ví dụ trên chặn tất cả các con bot của công cụ tìm kiếm thu thập dữ liệu, tất cả các URL trong thư mục con /color/ sẽ có dấu chấm hỏi.

Sử dụng ‘$’ để chỉ ra phần cuối của một URL

Ví dụ, nếu bạn muốn chặn các công cụ tìm kiếm khỏi việc truy cập vào tất cả các tệp .jpg trên trang web của bạn, bạn có thể liệt kê chúng một cách riêng biệt. Tuy nhiên, sẽ không hiệu quả nếu bạn làm như vậy.

Không nên:

User-agent: *

Disallow: /photo-a.jpg

Disallow: /photo-b.jpg

Disallow: /photo-c.jpgThay vào đó, bạn có thể thêm tính năng “$”, như sau:

Nên:

User-agent: *

Disallow: /*.jpg$Lưu ý: Trong ví dụ này, /dog.jpg không thể được cào, nhưng /dog.jpg?p=32414 có thể vì nó không kết thúc bằng “.jpg”.

Biểu thức “$” là một tính năng hữu ích trong những trường hợp cụ thể như trên. Tuy nhiên, nó cũng có thể ẩn chứa những mối nguy hại.

Bạn có thể dễ dàng bỏ chặn các thứ mà bạn không muốn, vì vậy hãy cẩn trọng khi áp dụng nó.

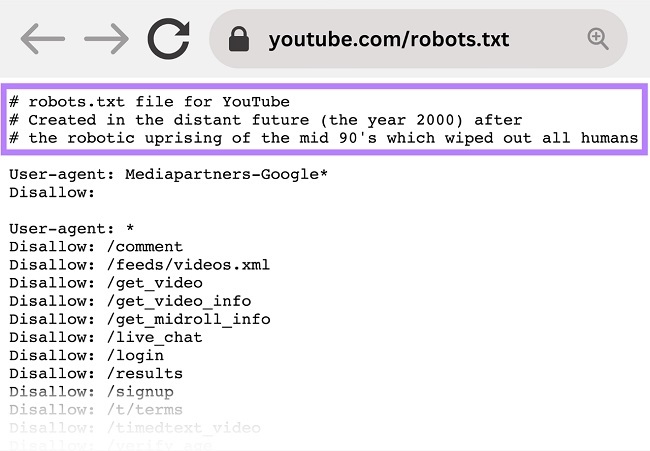

Sử dụng dấu thăng (#) để thêm bình luận

Các công cụ lục bỏ qua tất cả mọi thứ bắt đầu bằng dấu thăng (#).

Do đó, các nhà phát triển thường sử dụng dấu thăng để thêm bình luận vào tệp robots.txt. Điều này giúp giữ cho tệp được tổ chức và dễ đọc.

Để thêm bình luận, bắt đầu dòng bằng dấu thăng (#).

Ví dụ:

User-agent: *

#Landing Pages

Disallow: /landing/

Disallow: /lp/

#Files

Disallow: /files/

Disallow: /private-files/

#Websites

Allow: /website/*

Disallow: /website/search/*Các nhà phát triển đôi khi đưa các tin nhắn vui nhộn trong tệp robots.txt vì họ biết rằng người dùng hiếm khi nhìn thấy chúng.

Ví dụ, tệp robots.txt của YouTube có nội dung: “Được tạo ra trong tương lai xa xôi (năm 2000) sau cuộc khởi nghĩa của các robot vào giữa thập niên 90 đã xóa sổ tất cả con người”

Và tệp robots.txt của Nike có nội dung “just crawl it” (một lời nhắn tới khẩu hiệu “just do it”) cùng với logo của họ.

Kết luận

Tạo file robots.txt là một quá trình đơn giản, nhưng lại rất quan trọng để đảm bảo rằng trang web của bạn được tối ưu hóa cho các công cụ tìm kiếm. Bằng cách tạo file robots.txt, bạn có thể kiểm soát các bot của các công cụ tìm kiếm và giúp chúng hiểu được cách truy cập trang web của bạn. Hy vọng rằng sau khi đọc bài viết này, bạn đã hiểu rõ hơn về tạo file robots.txt và có thể áp dụng những kiến thức đó vào việc phát triển trang web của mình.

Chúc bạn thành công!